1530亿晶体管!AMD全新AI芯片欲单杀英伟达

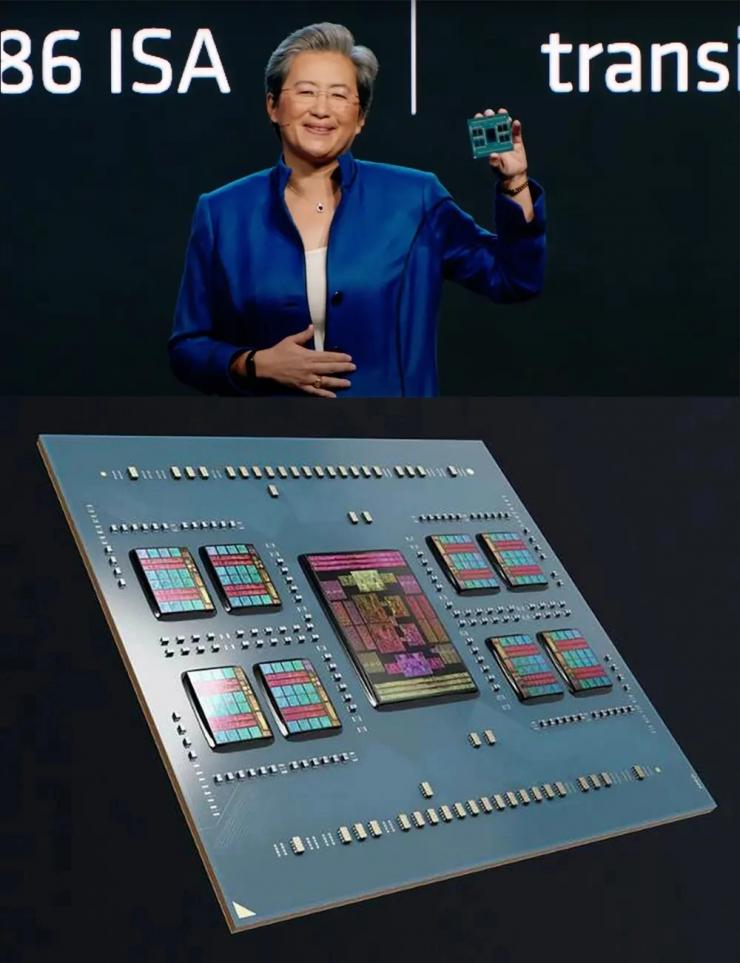

据业内信息报道,6月13日在美国旧金山举行的数据中心与人工智能技术发布会上,AMD正式发布了新一代的面向AI及HPC领域的GPU产品InstinctMI300系列,欲在AI芯片领域单杀英伟达。

其中,MI300A集成了1460亿个晶体管,MI300X更是集成了高达1530亿个晶体管,支持192GB的HBM3内存,几乎前面碾压了英伟达的H100芯片。此外AMD也推出了面向数据中心的第四代的Epyc产品。

AMDCEO苏姿丰认为,生成式AI和大语言模型(LLM)需要电脑的算力和内存大幅提高。预计今年,数据中心AI加速器的市场将达到300亿美元左右,到2027年将超过1500亿美元,复合年增长率超过50%。这意味着未来四年的CAGR将会超过50%。

正是基于AI加速器市场的庞大需求和高速增长趋势,AMD顺势推出了InstinctMI300系列,此次发布的包括MI300A和MI300X。

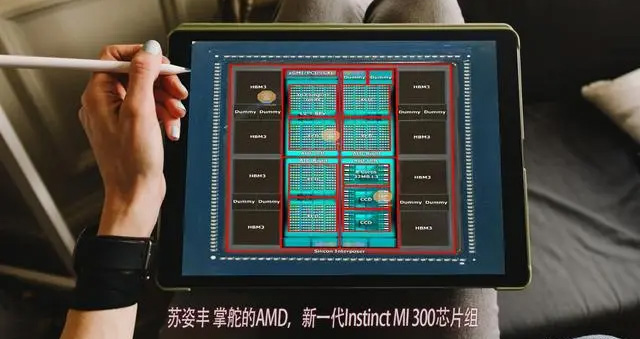

MI300A采用Chiplet设计,内部集成了13个小芯片,均基于台积电5nm/6nm制程工艺(CPU/GPU计算核心为5nm,HBM内存和I/O等为6nm),其中许多是3D堆叠的,以便创建一个面积可控的单芯片封装,总共集成1460亿个晶体管。

针对LLM进行优化的MI300X内部更是集成了12个5nm/6nm制程工艺的小芯片(HMB和I/O为6nm),拥有1530亿个晶体管,内核设计放弃了APU的24个Zen4内核和I/O芯片采用CDNA3GPU和更大的192GBHBM3内存,带来高达5.2TB/s的带宽和896GB/s的InfinityFabric带宽。

AMD表示MI300X提供的HBM密度是英伟达最新芯片H100的2.4倍,HBM带宽最高可达H100的1.6倍,MI300X减少了CPU和GPU之间的数据移动使得功耗和延迟大大降低,可以运行比英伟达H100芯片更大的模型。

AMD在此次发布会上还对第四代EPYC处理器家族进行了更新,包括面向云原生计算的“Bergamo”系列新产品以及代号为Genoa-X的第四代EPYC3DV-CacheCPU等。而且本次AMD总裁Victor·Peng表示要在开发软件生态系统上努力。

文章来自21IC电子网